前面一篇文章详细介绍了实战:在普通PC上部署DeepSeek 7.0B大模型,大家怀疑7.0b模型功能太少,只能进行简单对话,不能转化为生产力。今天我们这篇文章就详细介绍下,利用AnythingLLM搭建个人知识库,投喂相关素材,让DeepSeek真正成为我们的生产工具,拉到最后看测试视频。

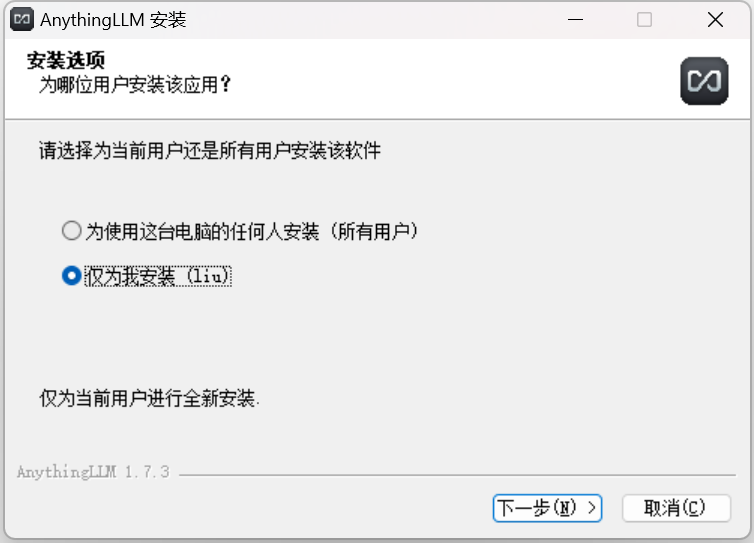

显卡:AMD Radeon Graphics (共享8G内存)AnythingLLM是由Mintplex Labs推出的创新应用,它巧妙融合了大型语言模型(LLM)技术,旨在重塑文档交互与管理的体验。这款全栈应用程序支持广泛的文档格式,包括但不限于PDF、TXT和DOCX,使用户能够以一种前所未有的方式与这些文档进行互动。它不仅能够解析和理解文档内容,还能根据用户的指令执行复杂的操作,如信息提取、内容编辑或格式调整。这种交互式的文档管理方式极大地提高了工作效率,使用户能够更快捷、更准确地处理各类文档任务。首先进入AnythingLLM的官网https://anythingllm.com/,点击“Download for desktop”。尝试无法下载或者下载很慢,可关注本微信公众号,回复AnythingLLM获取网盘下载地址。打开下载好的安装包,根据需要选择安装路径,最好默认在C盘,省得后面需要修改运行环境,软件将自动安装。

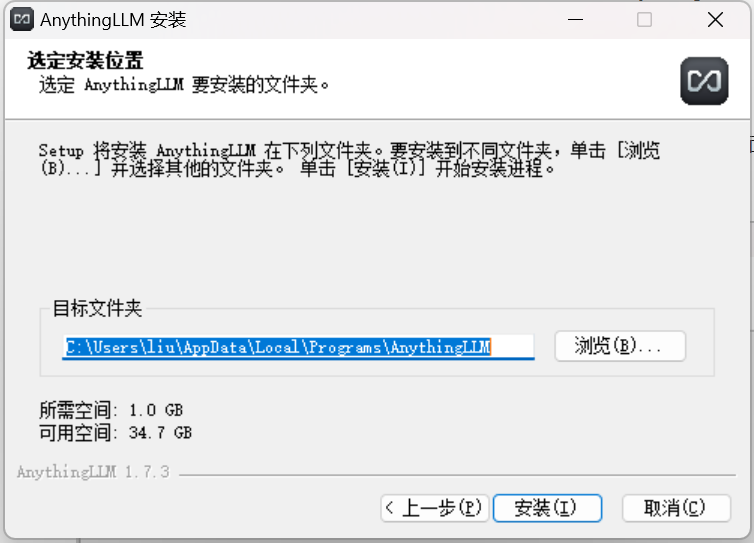

AnythingLLM安装文件不大,300M不到,但是安装过程十分缓慢,不知道是不是本电脑的配置较低的原因,安装时间达到了10多分钟。安装慢,大家慢慢等待,别着急。

打开AnythingLLM,如下界面,点击Getstarted

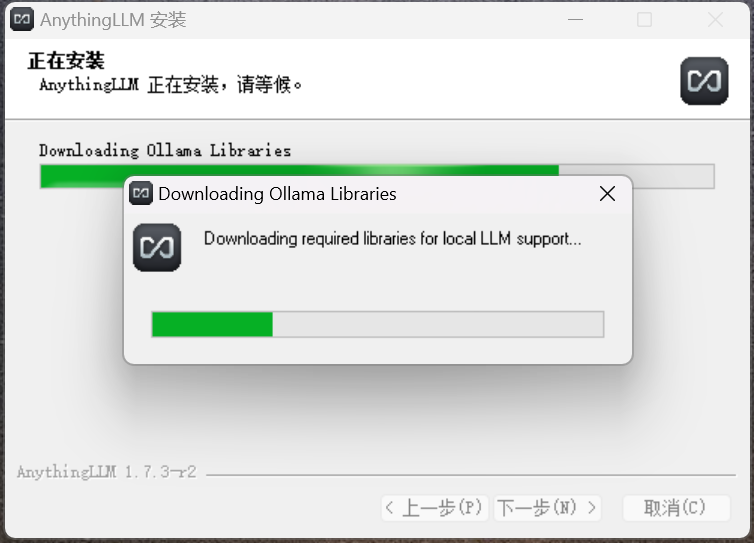

配置LLM Preference,因为之前我们配置了Ollama,所以我们选择Ollama,同时模型选择deepseek r1 7b,Max Tokens 默认。

点朝右箭头,开始下一步。

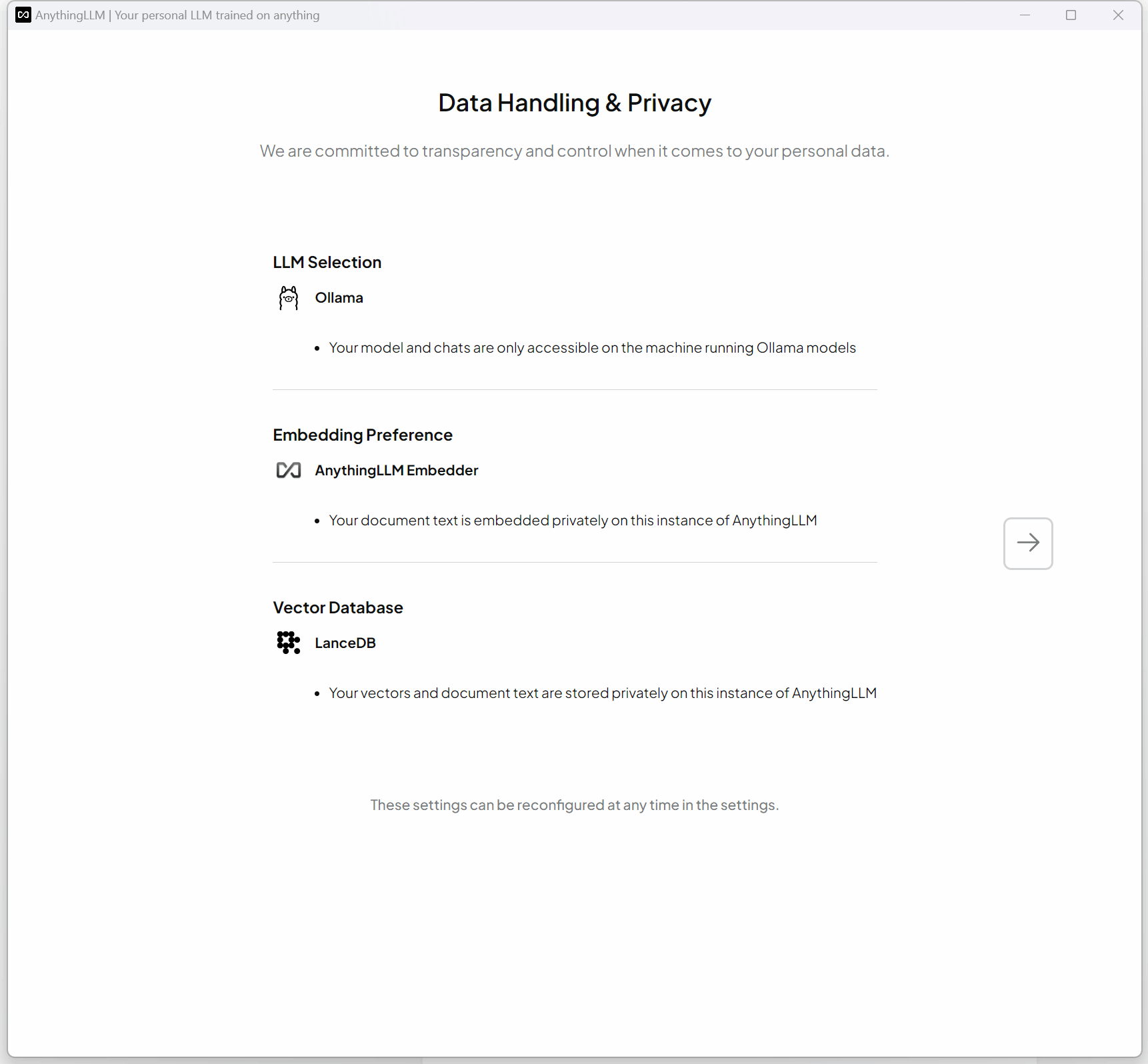

翻译下大致意思是:数据处理方面的隐私,意思是模型和相关聊天记录只能运行在Ollama的机器上访问。这个对于我们测试数据不影响,继续下一步。

这一步是要求填写相关信息,可以根据需要填写,也可以不填写,点击下一步

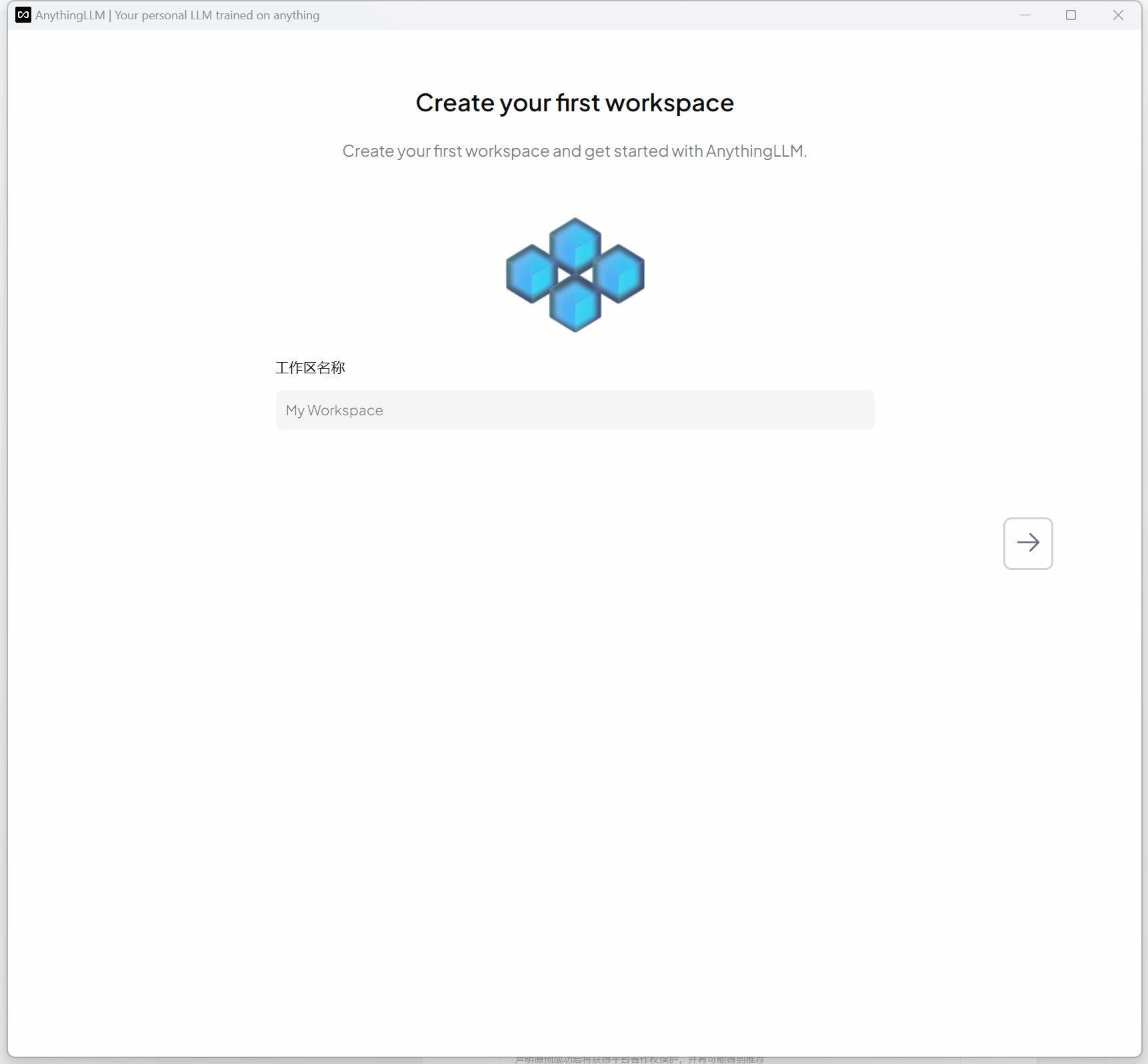

建立工作区名称,这里我们主要是测试,所以工作区名称就写Test,点击下一步。

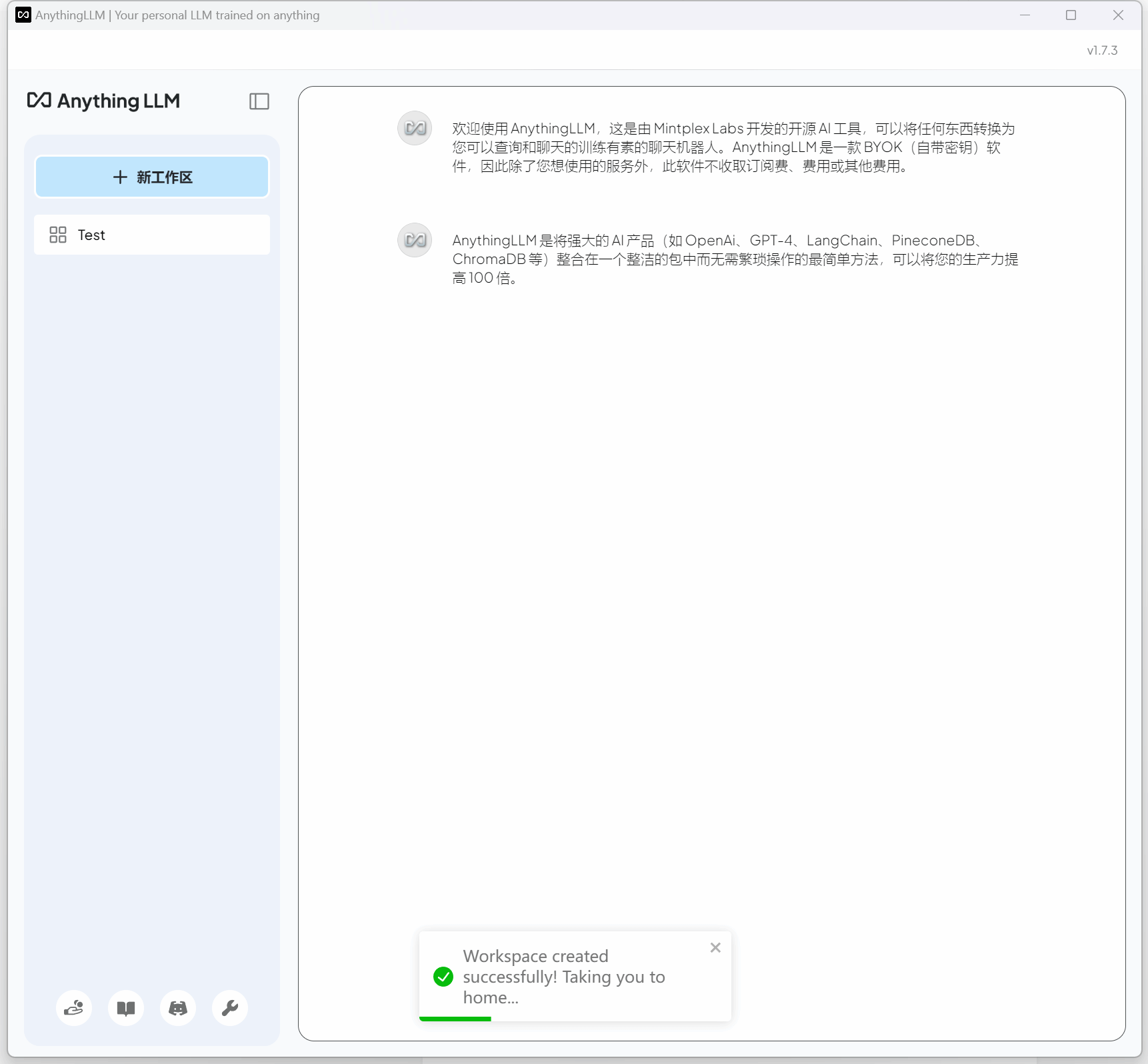

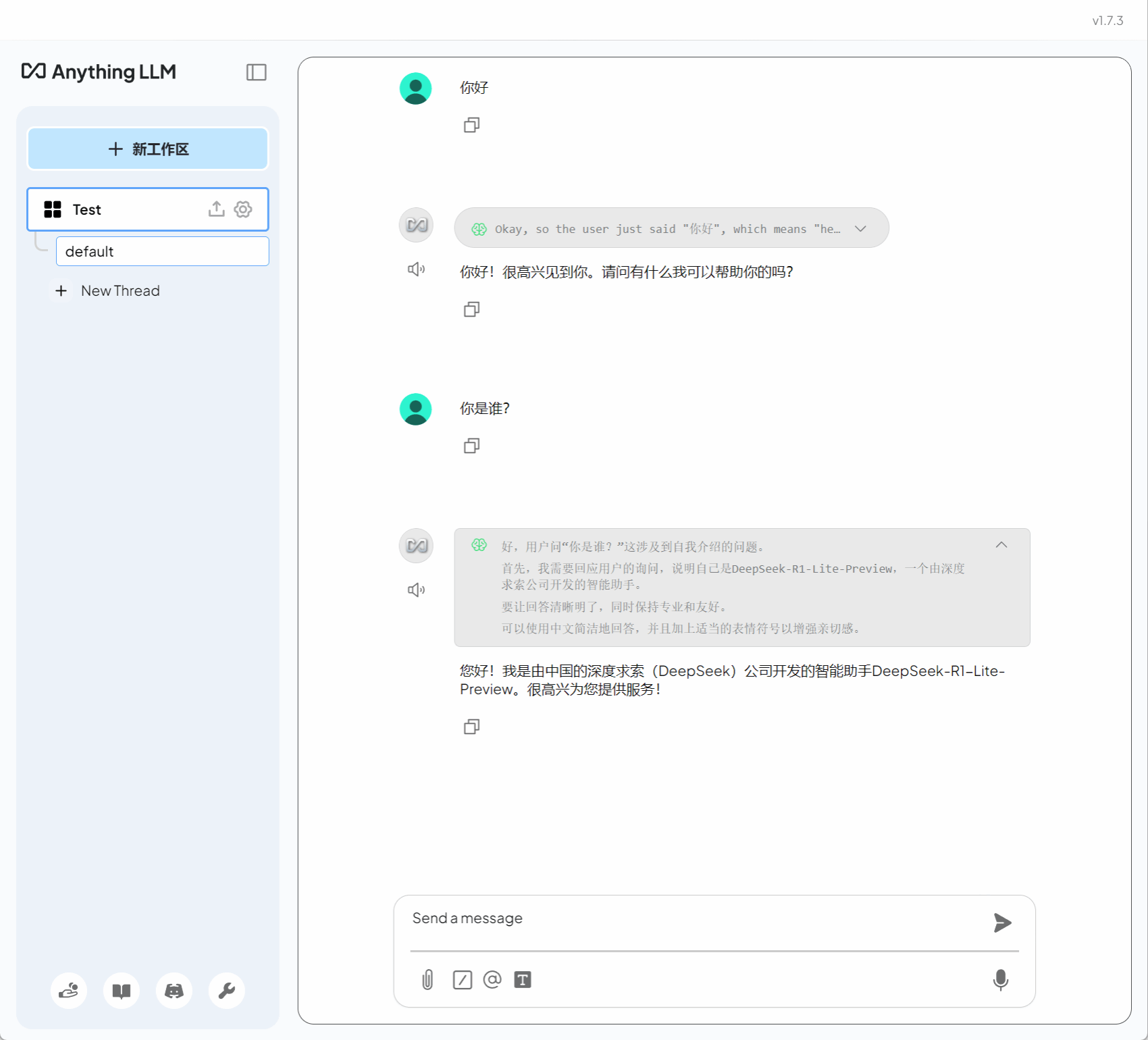

至此,我们的配置工作就已经完成了,进行环境测试。

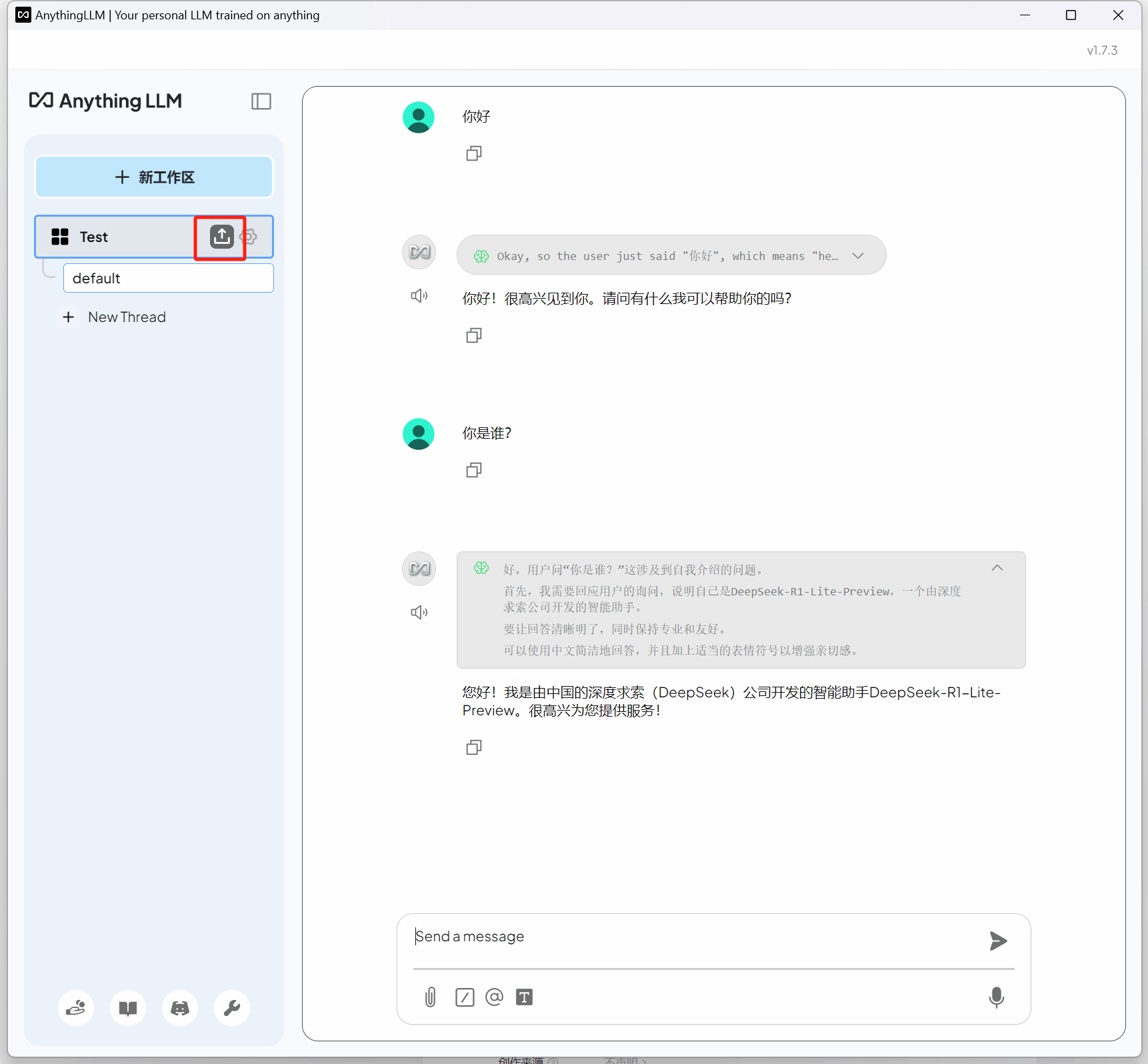

4.上传知识库

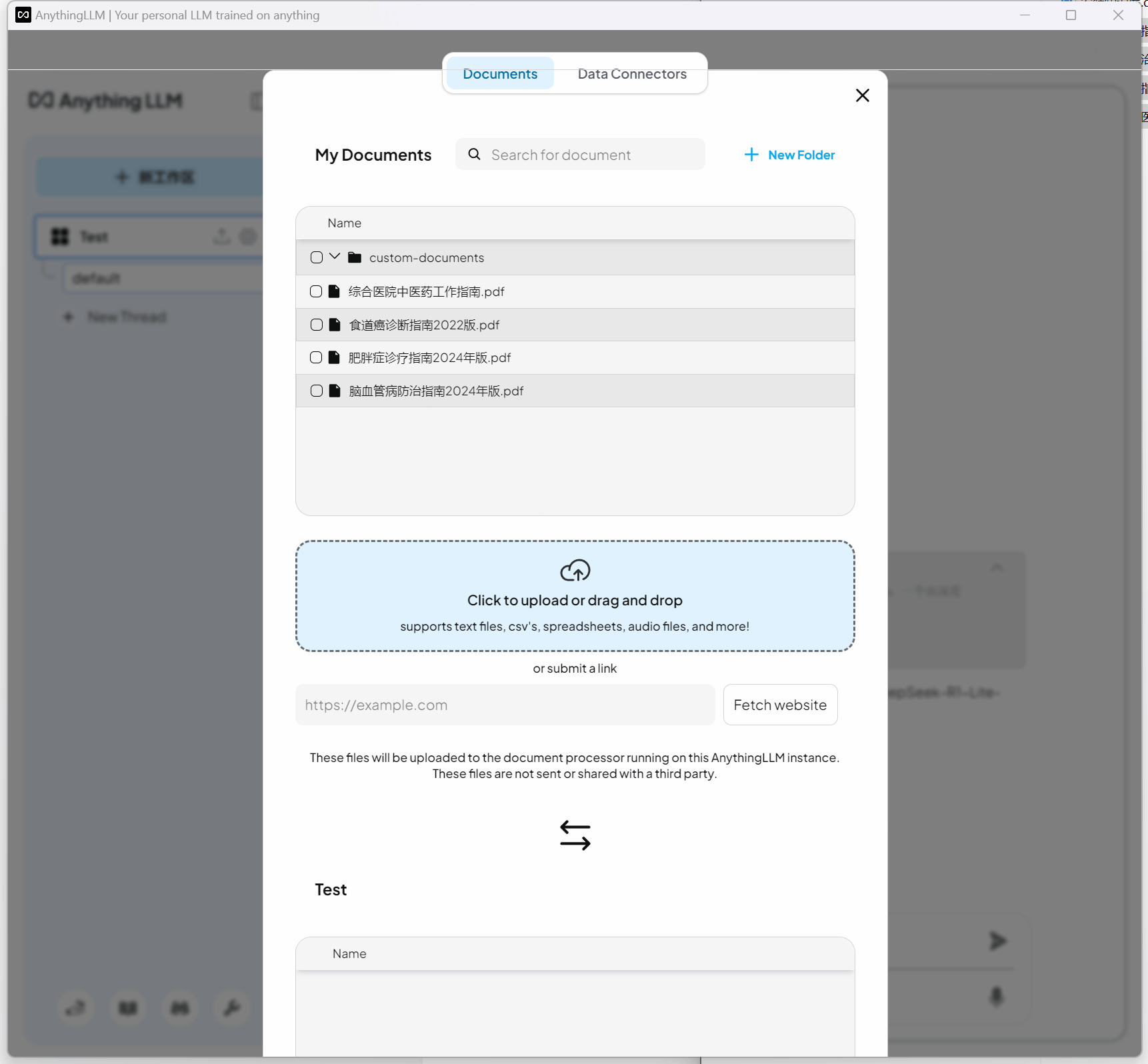

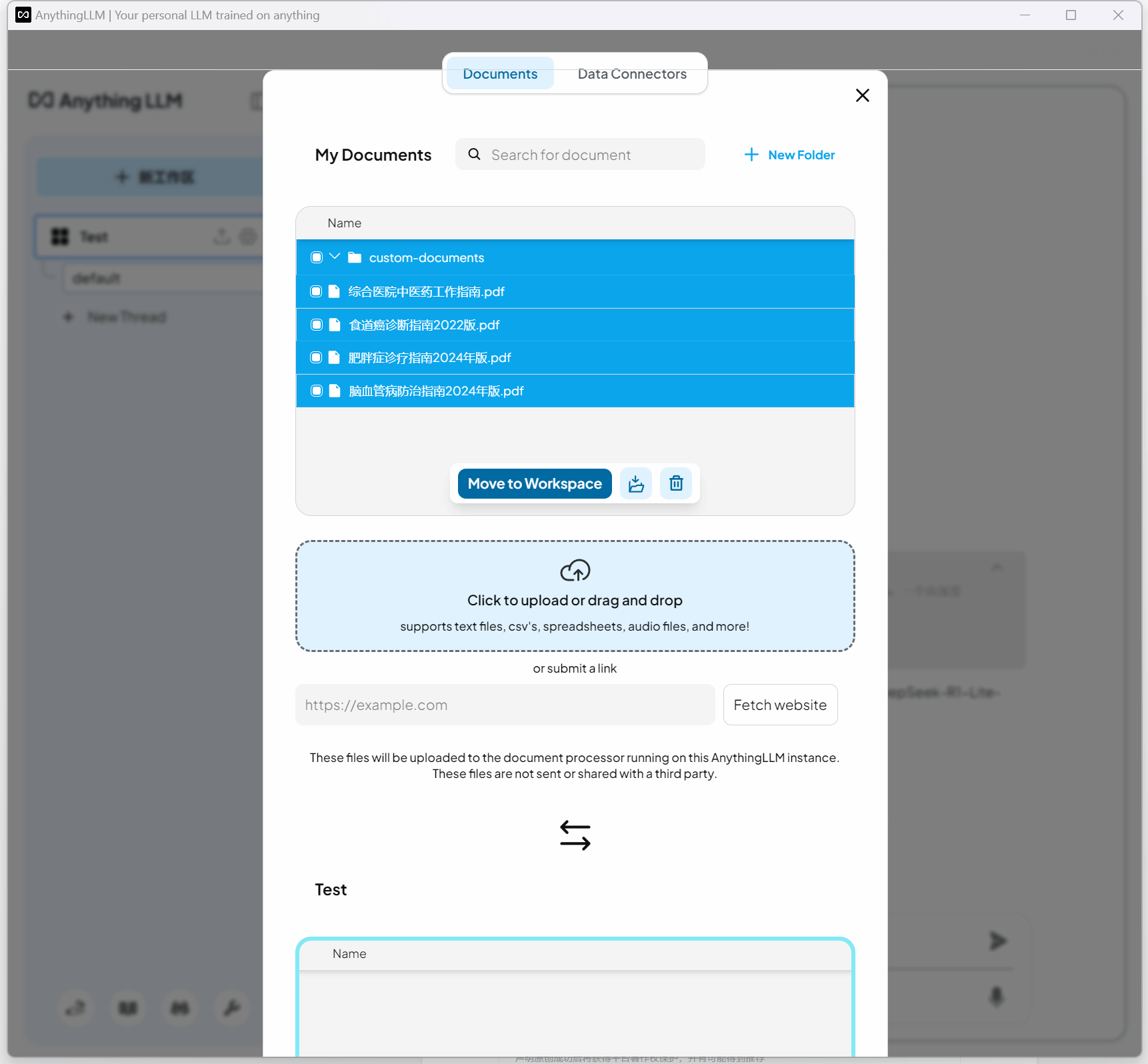

点击如上图所示,上传知识文件。我从网上下载了几份医学指南,PDF格式,30-70页不等,食道癌诊断指南2022版、脑血管病防治指南2024年版、肥胖症诊疗指南2024年版、综合医院中医药工作指南。

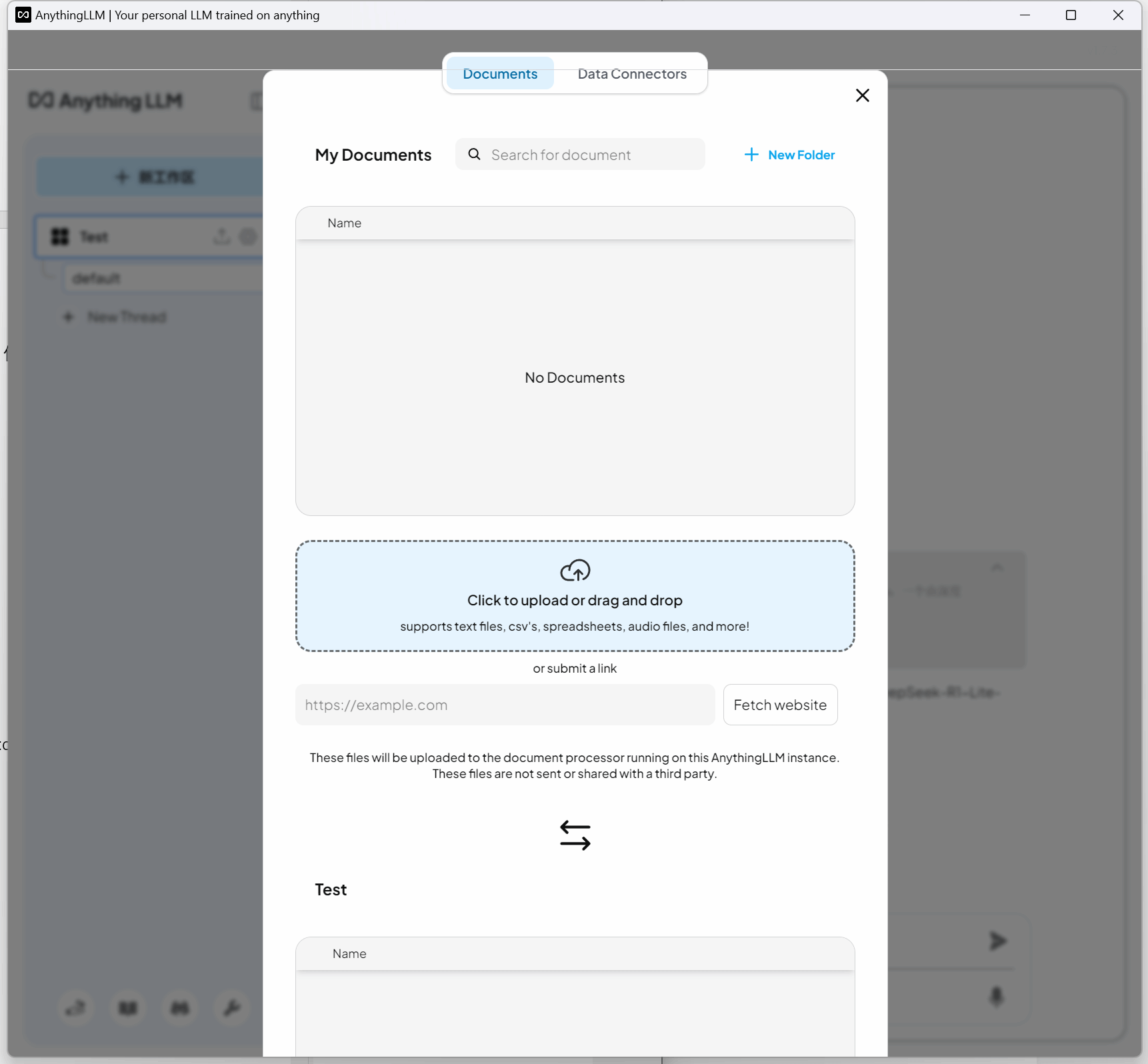

文件可以直接拉进去,也可以点击上传。

显示上传成功。

选中文件,点击“Move to Workspace”将文件移动到工作区。

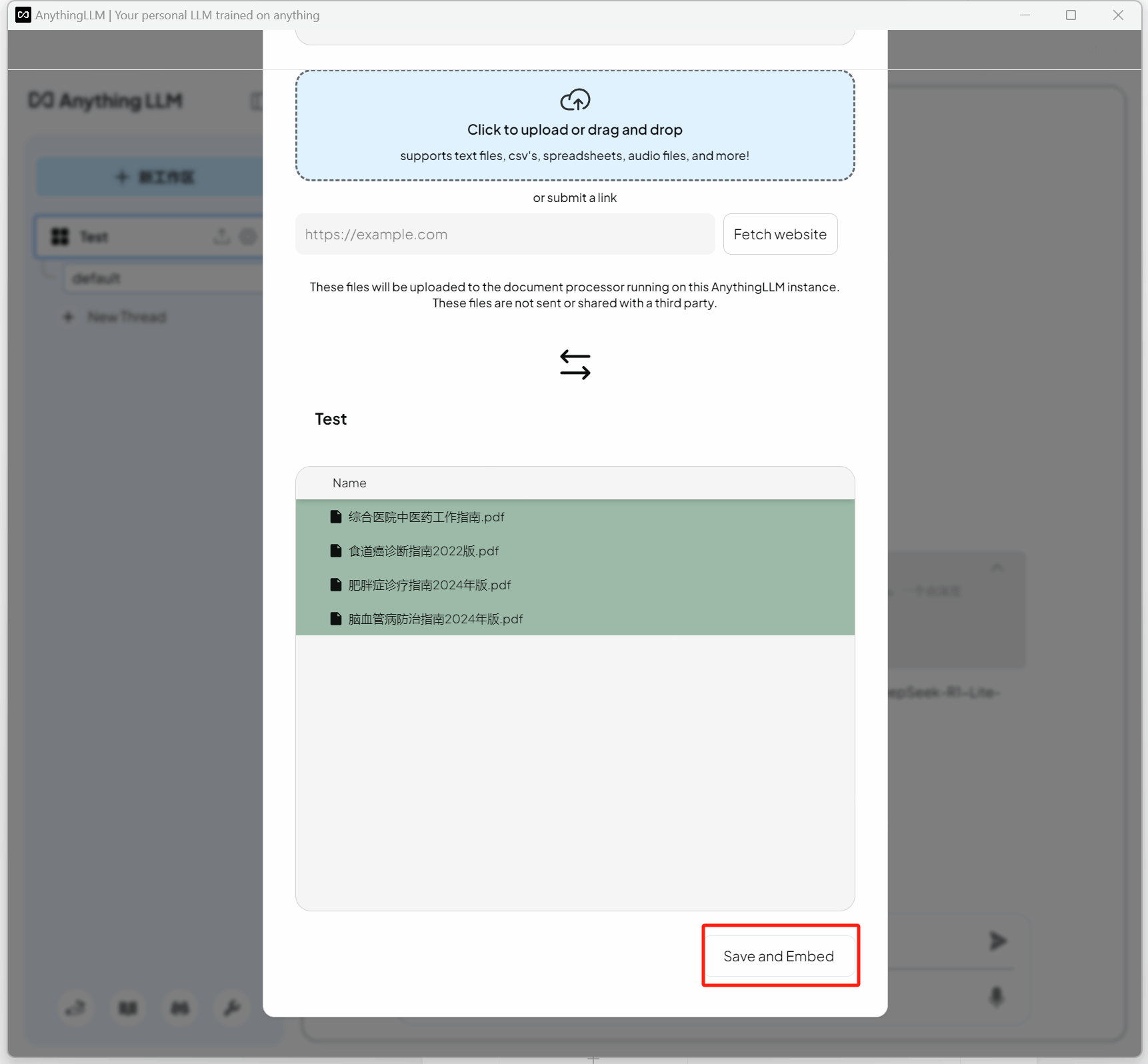

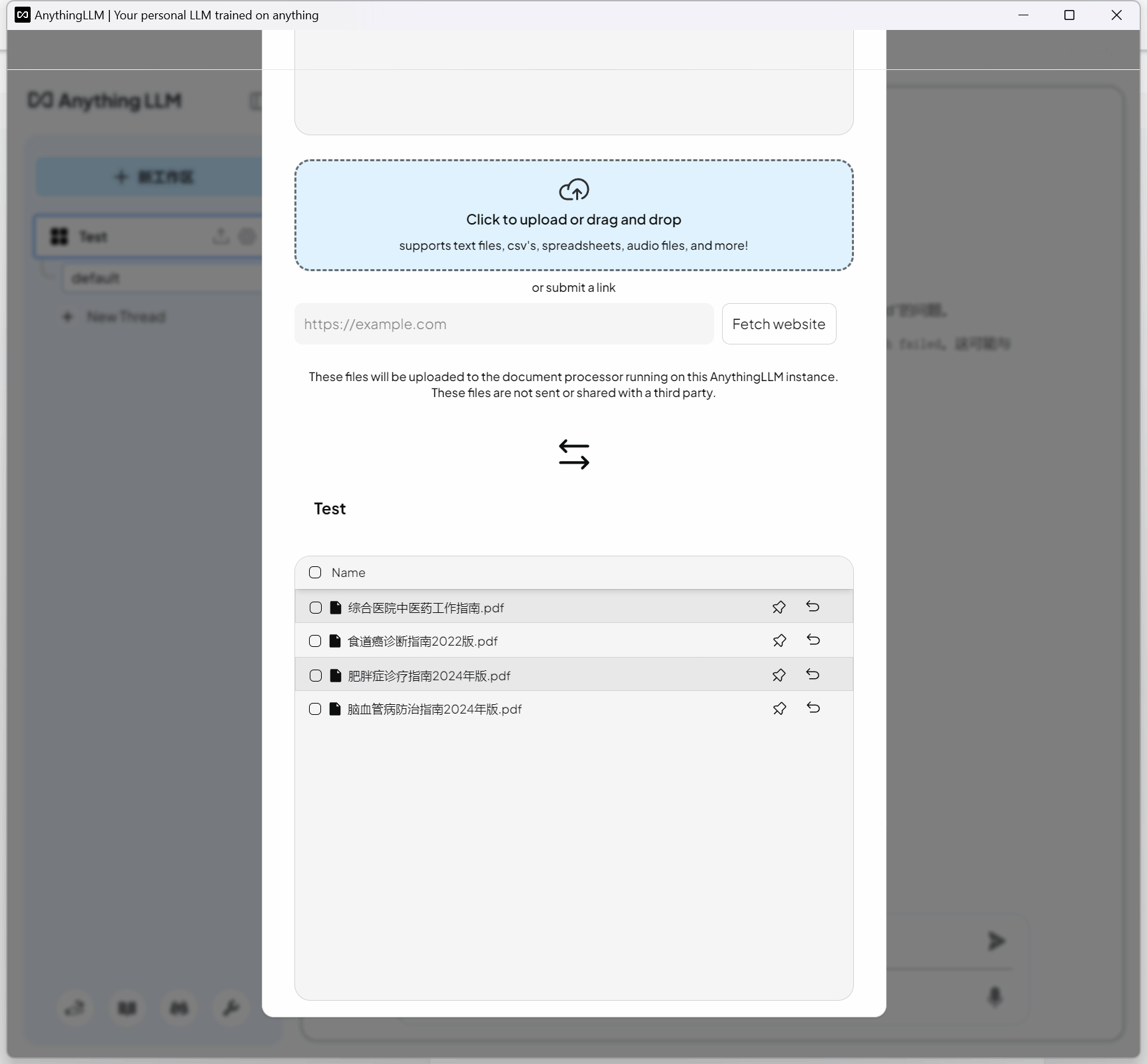

再点击“Save and Embed”。若文件较大,此步骤会消耗较长的时间。

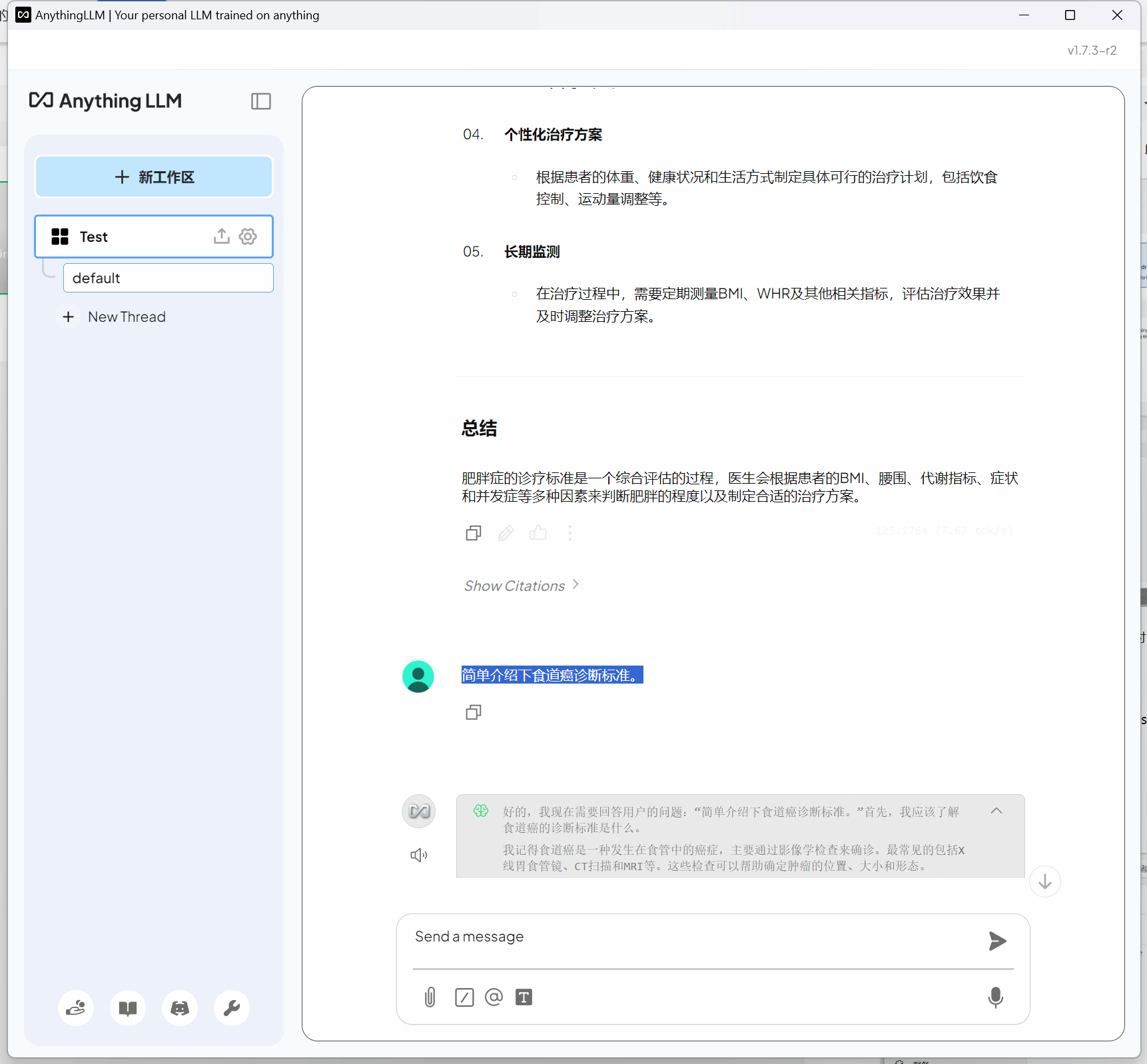

根据上传的知识库内容,我们尝试与deepseek,开展对话,测试相关效果和电脑资源使用情况。

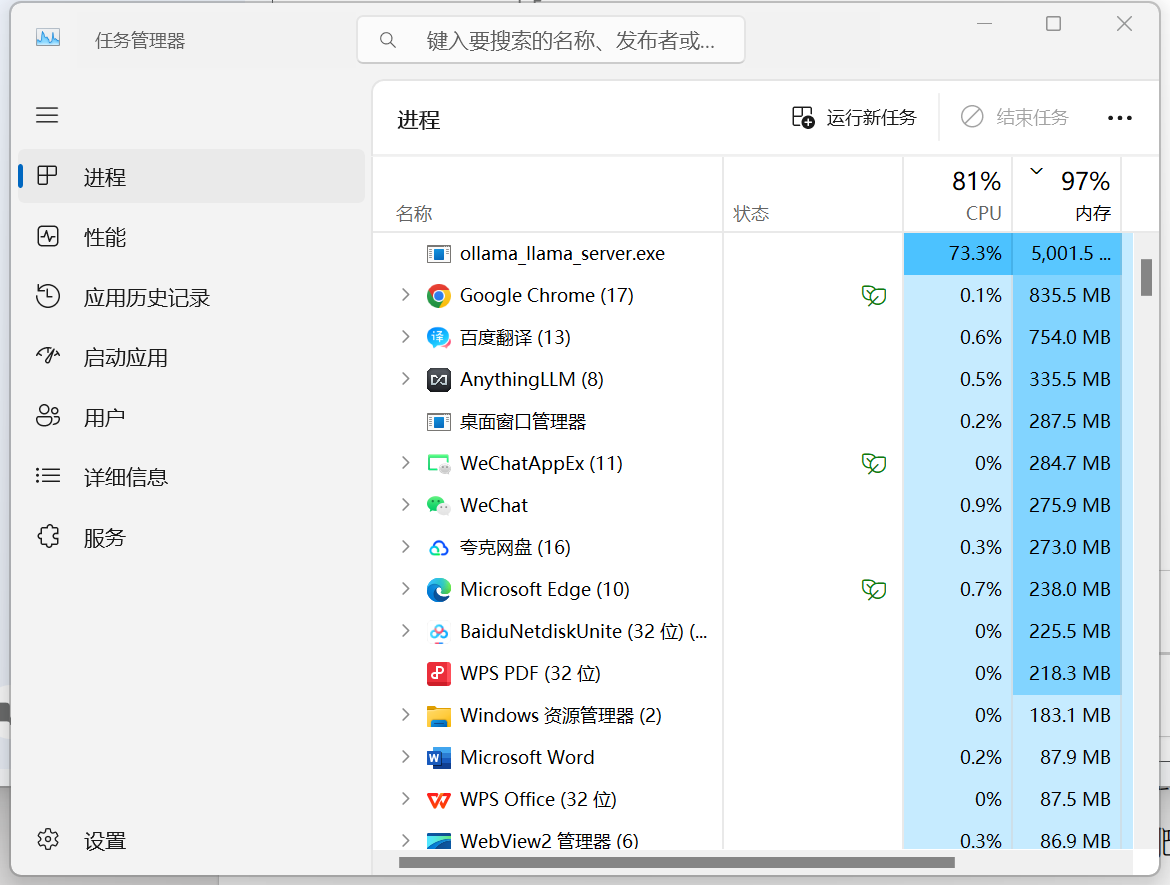

思考大约20秒后开始回答,有思考分析过程,输出答案总共花费1分55秒,明显感觉到电脑资源被消耗,但整体看是CPU和内存资源消耗得多,GPU资源相对还好。这也是因为电脑无独立显卡,共享内存的原因,大部分还是使用CPU进行分析,占用大量的内存。

实际测试下来,在AMD Ryzen 5 4600H,16G内存,无独立显卡的电脑上部署DeepSeek r1 7b,通过AnythingLLM部署知识库,开展对话响应时间尚可,回答也比较精准,基本可以实现本地知识库建设,满足一般爱好者和普通工作者需求。